NộI Dung

Q:

Tại sao các mạng thần kinh tái phát nhân tạo thường khó đào tạo?

A:

Khó khăn trong việc đào tạo mạng lưới thần kinh tái phát nhân tạo phải làm với sự phức tạp của chúng.

Một trong những cách đơn giản nhất để giải thích tại sao các mạng thần kinh tái phát khó đào tạo là chúng không phải là mạng lưới thần kinh phản hồi.

Trong các mạng thần kinh feedforward, tín hiệu chỉ di chuyển một chiều. Tín hiệu di chuyển từ một lớp đầu vào sang các lớp ẩn khác nhau và chuyển tiếp sang lớp đầu ra của một hệ thống.

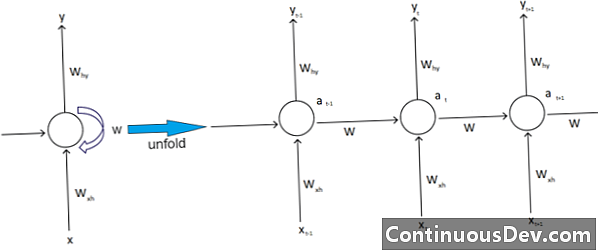

Ngược lại, các mạng thần kinh tái phát và các loại mạng thần kinh khác nhau có các chuyển động tín hiệu phức tạp hơn. Được phân loại là phản hồi mạng Mạng, mạng thần kinh định kỳ có thể có tín hiệu truyền cả về phía trước và phía sau và có thể chứa nhiều vòng lặp khác nhau trong mạng nơi các số hoặc giá trị được đưa trở lại mạng. Các chuyên gia liên kết điều này với khía cạnh của các mạng thần kinh tái phát liên quan đến bộ nhớ của họ.

Ngoài ra, có một loại phức tạp khác ảnh hưởng đến mạng lưới thần kinh tái phát. Một ví dụ tuyệt vời về điều này là trong lĩnh vực xử lý ngôn ngữ tự nhiên.

Trong xử lý ngôn ngữ tự nhiên tinh vi, mạng lưới thần kinh cần có khả năng ghi nhớ mọi thứ. Nó cũng cần phải có đầu vào trong con. Giả sử có một chương trình muốn phân tích hoặc dự đoán một từ trong câu của các từ khác. Ví dụ, có thể có một độ dài cố định năm từ để hệ thống đánh giá. Điều đó có nghĩa là mạng lưới thần kinh phải có đầu vào cho mỗi từ này, cùng với khả năng nhớ nhớ hay luyện tập trên các từ này. Đối với những lý do tương tự và khác, các mạng thần kinh tái phát thường có các vòng lặp và phản hồi ẩn nhỏ trong hệ thống.

Các chuyên gia than thở rằng những biến chứng này gây khó khăn cho việc đào tạo các mạng. Một trong những cách phổ biến nhất để giải thích điều này là bằng cách trích dẫn vấn đề độ dốc phát nổ và biến mất. Về cơ bản, các trọng số của mạng sẽ dẫn đến nổ tung hoặc biến mất các giá trị với số lượng lớn các đường chuyền.

Nhà tiên phong mạng lưới thần kinh Geoff Hinton giải thích hiện tượng này trên web bằng cách nói rằng các đường truyền tuyến tính lạc hậu sẽ khiến trọng lượng nhỏ hơn co lại theo cấp số nhân và trọng lượng lớn hơn để phát nổ.

Vấn đề này, ông tiếp tục, trở nên tồi tệ hơn với các chuỗi dài và nhiều bước thời gian hơn, trong đó các tín hiệu tăng hoặc giảm. Khởi tạo trọng lượng có thể giúp ích, nhưng những thách thức đó được tích hợp vào mô hình mạng thần kinh tái phát. Có luôn luôn là vấn đề gắn liền với thiết kế và xây dựng cụ thể của họ. Về cơ bản, một số loại mạng thần kinh phức tạp hơn thực sự thách thức khả năng của chúng ta dễ dàng quản lý chúng. Chúng ta có thể tạo ra một mức độ phức tạp thực tế vô hạn, nhưng chúng ta thường thấy những thách thức về khả năng dự đoán và khả năng mở rộng tăng lên.